DeepSeek的负担能力是一个神话:革命性的AI实际上花费了16亿美元

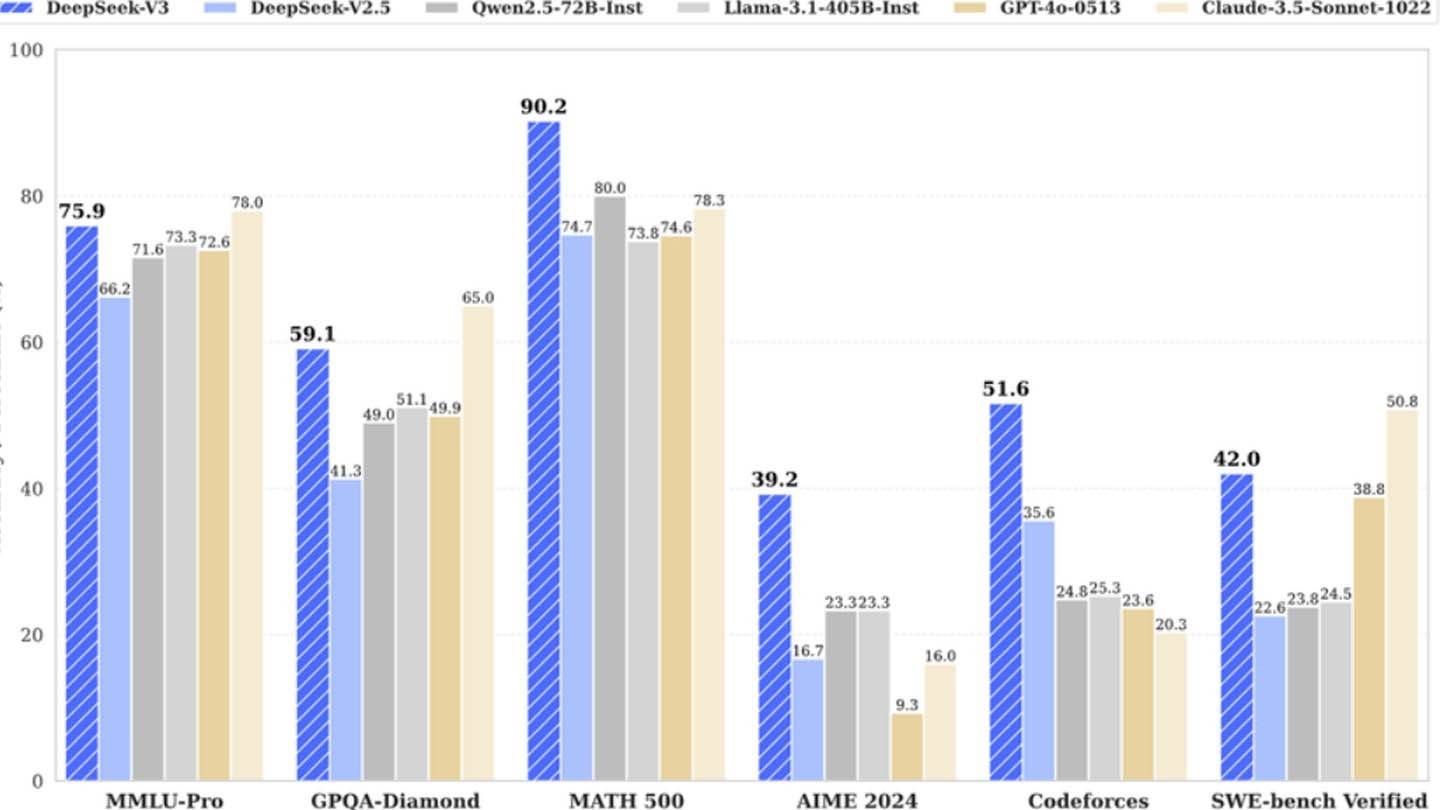

DeepSeek的新聊天机器人拥有令人印象深刻的介绍:“嗨,我被创建了,您可以问任何东西,并得到一个甚至可能让您感到惊讶的答案。”这种AI是中国初创公司DeepSeek的产物,已迅速成为主要参与者,甚至导致NVIDIA的股价大幅下降。它的成功源于一种独特的建筑和培训方法,结合了几种创新技术。

多语预测(MTP):与一次预测一个单词的传统模型不同,MTP同时预测了多个单词,分析了不同的句子零件,以提高准确性和效率。

专家的混合(MOE):该体系结构利用多个神经网络来处理输入数据,加速培训并增强性能。 DeepSeek V3使用256个网络,每个令牌都激活了8个网络。

多头潜在注意力(MLA):这种机制着重于关键的句子元素,反复从文本片段中提取关键细节,以最大程度地减少信息丢失并捕获细微的细微差别。

DeepSeek最初声称使用2048 GPU培训了其强大的DeepSeek V3神经网络,仅需600万美元。但是,半分析显示出更广泛的基础设施:大约50,000个NVIDIA HOPPER GPU,包括10,000 H800,10,000 H100和其他H20,分布在多个数据中心。这代表了一笔总额约16亿美元的服务器投资,运营费用估计为9.44亿美元。

高级对冲基金的子公司DeepSeek拥有其数据中心,这与许多依靠云服务的初创公司不同。这为优化和更快的创新实施提供了更大的控制。该公司的自我资助性质提高了灵活性和决策速度。此外,DeepSeek吸引了顶尖人才,一些研究人员每年收入超过130万美元,主要来自中国大学。

虽然最初的600万美元培训成本索赔似乎是不现实的,但仅向预培训的GPU使用以及排除研究,改进,数据处理和基础设施 - 深处已经在AI开发方面投资了超过5亿美元。与更大的官僚主义公司相比,其紧凑的结构有助于有效的创新实施。

DeepSeek的成功凸显了资金丰富,独立的AI公司的竞争潜力。但是,它的成就源于实质性的投资,技术突破和强大的团队,使“革命预算”声称过度简化。尽管如此,DeepSeek的成本仍大大低于竞争对手。例如,与Chatgpt 4的1亿美元相比,其R1型号培训的成本为500万美元。但是,它仍然比竞争对手便宜。

-

Firaxis Games,《文明7》的开发商,今日已裁员若干名员工。此举发生在Take-Two Interactive首席执行官斯特劳斯·泽尔尼克近期表示该游戏销量符合公司预期之后。 多名Firaxis员工在社交媒体上宣布,自己是今日裁员名单中的一员,涉及制作、叙事和美术等多个部门。《文明7》的发行商2K已向游戏开发者媒体确认了此次人员缩减。公司表示,工作室正在进行重组,以优化开发流程,提升“适应性、协作性与创造力”。2K未公布受影响员工的具体人数。 《文明7》今年早些时候发布,其在Steam作者 : Joshua Mar 12,2026

-

索尼在2025年6月的“State of Play”活动中,意外公布了由《俄罗斯方块效应》开发商梅津宏明(Tetsuya Mizuguchi)打造的新作《Lumines Arise》。 该游戏将于2025年秋季登陆PlayStation 5与PS VR2,夏季将推出试玩版。首发宣传片如下: 播放在PlayStation博客的一篇帖子中,Enhance部门总监石原孝司表示,《Lumines Arise》是专为下一代平台全新打造的作品,作为二十年前首发于PlayStation Portable的经典作者 : Stella Mar 08,2026