DeepSeek의 경제성은 신화입니다. 혁명 AI는 실제로 개발하는 데 16 억 달러가 들었습니다.

DeepSeek의 새로운 챗봇은 인상적인 소개를 자랑합니다. "안녕하세요, 나는 당신이 무엇이든 물어보고 당신을 놀라게 할 수있는 답을 얻을 수 있도록 만들어졌습니다." 중국 스타트 업 Deepseek의 제품인이 AI는 빠르게 주요 선수가되어 Nvidia의 주가가 크게 하락하기까지했습니다. 성공은 몇 가지 혁신적인 기술을 통합 한 독특한 아키텍처 및 교육 방법론에서 비롯됩니다.

MTP (Multi-Token Prediction) : 한 번에 한 단어를 예측하는 전통적인 모델과 달리 MTP는 여러 단어를 동시에 예측하여 정확도와 효율성을 향상시키기 위해 다른 문장 부분을 분석합니다.

전문가 (MOE)의 혼합 : 이 아키텍처는 여러 신경망을 사용하여 입력 데이터를 처리하고 교육을 가속화하고 성능을 향상시킵니다. DeepSeek V3는 256 개의 네트워크를 사용하여 각 토큰 당 8 개를 활성화합니다.

다중 헤드 잠재주의 (MLA) : 이 메커니즘은 중요한 문장 요소에 중점을 두어 텍스트 조각에서 주요 세부 정보를 반복적으로 추출하여 정보 손실을 최소화하고 미묘한 뉘앙스를 포착합니다.

Deepseek은 처음에 2048 GPU를 사용하여 강력한 DeepSeek V3 Neural Nework를 6 백만 달러에 불과했다고 주장했습니다. 그러나 Semianalysis는 10,000 H800, 10,000 H100 및 추가 H20을 포함하여 약 50,000 NVIDIA HOPPER GPU가 여러 데이터 센터에 퍼져있는 훨씬 더 광범위한 인프라를 나타 냈습니다. 이는 약 16 억 달러의 총 서버 투자를 나타내며 운영 비용은 9 억 9,400 만 달러로 추정됩니다.

High-Flyer 헤지 펀드의 자회사 인 Deepseek는 클라우드 서비스에 의존하는 많은 신생 기업과 달리 데이터 센터를 소유하고 있습니다. 이를 통해 최적화에 대한 제어력을 높이고 더 빠른 혁신 구현을 제공합니다. 회사의 자체 자금 지원 자연은 유연성과 의사 결정 속도를 향상시킵니다. 또한 Deepseek은 최고의 인재를 유치하며 일부 연구자들은 주로 중국 대학에서 매년 130 만 달러 이상을 벌고 있습니다.

초기 6 백만 달러의 교육 비용 청구는 비현실적인 것으로 보이지만 GPU 사용을 사전 훈련하고 연구, 개선, 데이터 처리 및 인프라를 제외한 것만으로도 비현실적으로 보이지만 DeepSeek은 AI 개발에 5 억 달러 이상을 투자했습니다. 소형 구조는 더 큰 관료적 회사에 비해 효율적인 혁신 구현을 촉진합니다.

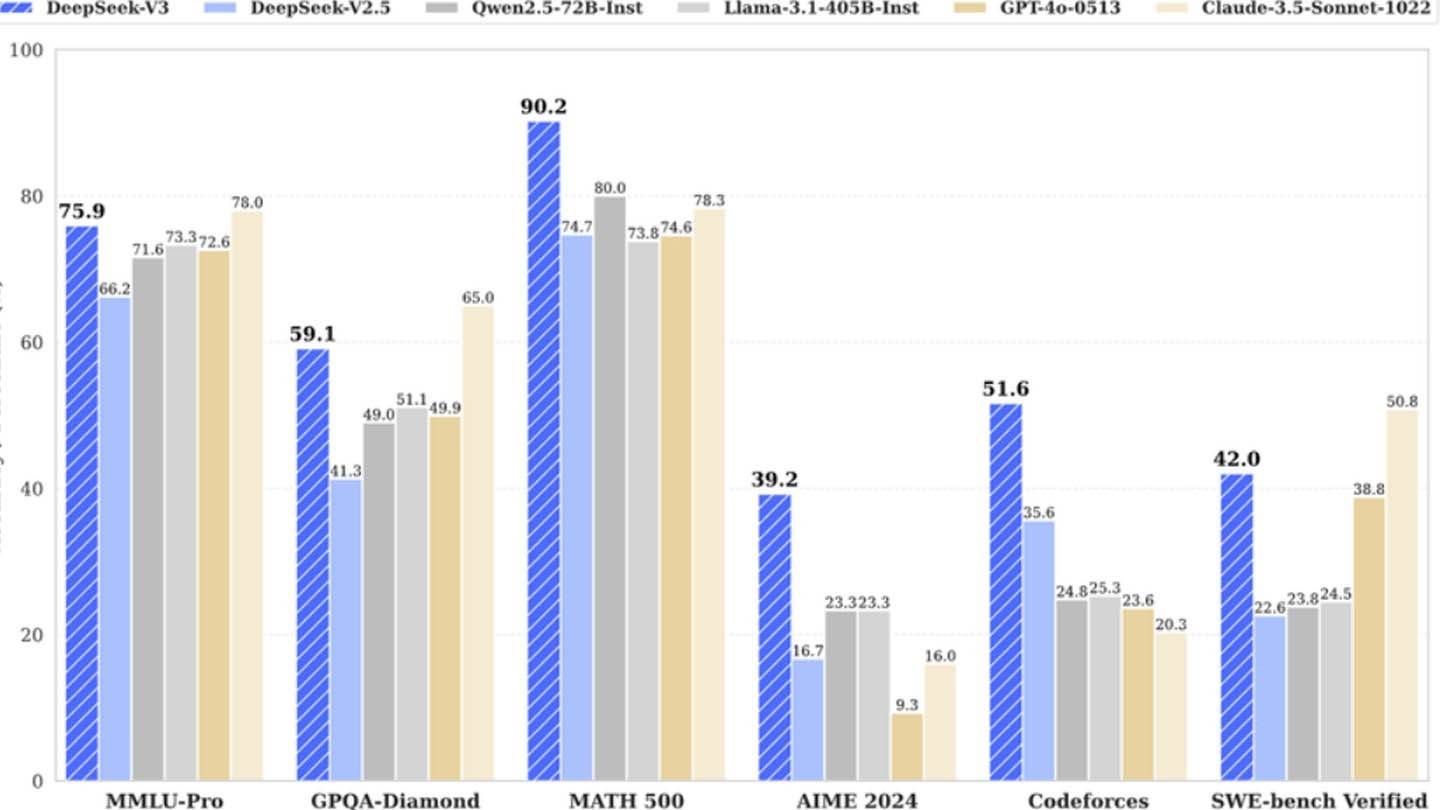

DeepSeek의 성공은 잘 자금을 지원받는 독립 AI 회사의 경쟁 잠재력을 강조합니다. 그러나 그 성과는 상당한 투자, 기술 혁신 및 강력한 팀에 뿌리를두고 있으며, "혁신적인 예산"은 지나치게 단순화됩니다. 그럼에도 불구하고 DeepSeek의 비용은 경쟁 업체보다 훨씬 낮습니다. 예를 들어, R1 모델 교육 비용은 Chatgpt 4의 1 억 달러에 비해 5 백만 달러입니다. 그러나 경쟁사보다 여전히 저렴합니다.

-

Firaxis Games는 '시빌리제이션 VII'의 개발사로, 오늘 불확실한 수의 직원을 해고했다. 이는 게임의 판매가 회사의 예측에 부합하고 있다는 테이크-투 인터랙티브의 스트라우스 젤닉 CEO의 최근 발언에도 불구하고 발생한 일이다. 시빌리제이션 VII의 여러 Firaxis 직원들이 소셜 미디어를 통해 오늘의 해고에 포함된 것으로 밝혔으며, 이는 제작, 스토리라인, 예술 부서에 걸쳐 있다. 시빌리제이션 VII의 출판사인 2K는 게임 개발자에작가 : Joshua Mar 12,2026

-

소니는 2025년 6월 스테이트 오브 플레이에서 테트리스 이펙트 개발자 메즈구치 셰츠야가 제작한 루미네스 아라이즈(Lumines Arise)의 놀라운 발표로 이벤트를 시작했다. 이 게임은 플레이스테이션 5 및 PS VR2용으로 2025년 가을에 출시되며, 이번 여름에 체험판이 공개될 예정이다. 첫 번째 트레일러는 아래에서 확인할 수 있다: Play플레이스테이션 블로그의 포스트에서 테이카시 이시하라 감독(Enhance)은 루미네스 아라이즈가 20작가 : Stella Mar 08,2026