Deepseekの手頃な価格は神話です。革新的なAIは実際には16億ドルの費用がかかります。

Deepseekの新しいチャットボットには、印象的な紹介があります。中国のスタートアップDeepseekの製品であるこのAIは、すぐに主要なプレーヤーになり、Nvidiaの株価の大幅な低下に貢献しています。その成功は、いくつかの革新的な技術を組み込んだユニークなアーキテクチャとトレーニング方法に由来しています。

マルチトークン予測(MTP):一度に1つの単語を予測する従来のモデルとは異なり、MTPは複数の単語を同時に予測し、異なる文章を分析して精度と効率が向上します。

専門家の混合(MOE):このアーキテクチャは、複数のニューラルネットワークを利用して入力データを処理し、トレーニングの加速とパフォーマンスの向上を利用しています。 Deepseek V3は256のネットワークを採用し、トークンごとに8つのネットワークをアクティブにします。

マルチヘッド潜在的注意(MLA):このメカニズムは、重要な文化要素に焦点を当てており、テキストフラグメントから重要な詳細を繰り返し抽出して、情報の損失を最小限に抑え、微妙なニュアンスをキャプチャします。

Deepseekは当初、2048 GPUを使用して600万ドルで強力なDeepseek V3ニューラルネットワークを訓練したと主張しました。ただし、セミアン癒合により、はるかに広範なインフラストラクチャが明らかになりました。10,000H800、10,000 H100、および追加のH20を含む約50,000のNVIDIAホッパーGPUが複数のデータセンターに広がっています。これは、サーバーの総投資額を約16億ドルで、運用費用は9億4,400万ドルと推定されています。

クラウドサービスに依存している多くのスタートアップとは異なり、ハイフライヤーヘッジファンドの子会社であるDeepseekはデータセンターを所有しています。これにより、最適化とイノベーションの実装を高めることをより強力に制御できます。同社の自己資金による性質は、柔軟性と意思決定速度を向上させます。さらに、Deepseekはトップの才能を引き付け、一部の研究者は主に中国の大学から年間130万ドル以上を稼いでいます。

最初の600万ドルのトレーニングコストの請求は非現実的であるように見えますが、GPUの使用前のみを選択し、研究、洗練、データ処理、インフラストラクチャを除外しますが、DeepseekはAI開発に5億ドル以上を投資しています。そのコンパクトな構造は、より大きな官僚的企業と比較して、効率的なイノベーションの実装を促進します。

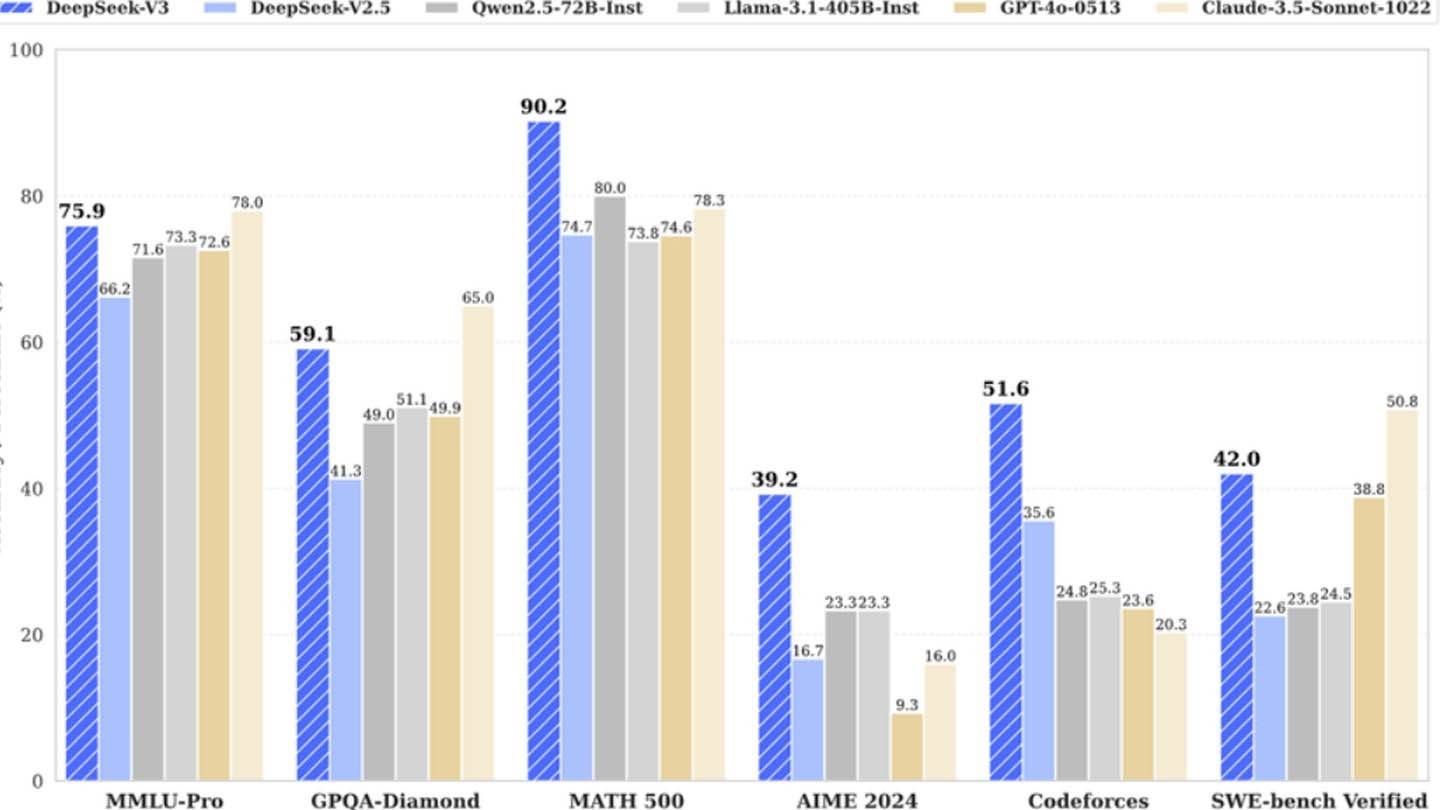

Deepseekの成功は、資金提供された独立したAI企業の競争の可能性を強調しています。ただし、その成果は、実質的な投資、技術的なブレークスルー、強力なチームに根ざしており、「革新的な予算」を単純化しすぎたと主張しています。それにもかかわらず、DeepSeekのコストは競合他社よりも大幅に低いままです。たとえば、R1モデルのトレーニングは、ChatGPT 4の1億ドルと比較して500万ドルかかります。ただし、競合他社よりも安いです。

-

『文明VII』の開発を手がけるフィラキシス・ゲームズは、本日、人数不定の社員をリストラした。この措置は、先日、Take-Two Interactiveのストラウス・ゼルニックCEOが『文明VII』の販売実績が同社の予測を上回っていると述べたばかりのタイミングで行われた。 複数のフィラキシス社員が、SNS上で本日のリストラに参加したことを発表しており、制作、ストーリー、アート部門にわたる。『文明VII』の発売元である2Kは、ゲームデベロッパーに対し、人材削減を確認した。同社は、開発プロセスを最適化著者 : Joshua Mar 12,2026

-

ソニーは、2025年6月の「State of Play」の冒頭で、『テトリスエフェクト』の開発者である水口哲也氏が手がける『Lumines Arise』の驚きの発表を行いました。 本作は2025年秋にプレイステーション5およびPS VR2向けにリリース予定で、デモは今年の夏に登場予定です。初公開のトレーラーは以下の通りです: 再生プレイステーションブログの投稿で、エンハンスディレクターの石原孝司氏は、「Lumines Arise」は20年前にプレイステーション・ポータブルで始まったクラシックな『著者 : Stella Mar 08,2026